近日,BETVLCTOR伟德中文网站程科教授團隊在行人重識别(ReID)研究方向取得新進展,團隊研究成果“MSCMNet: Multi-scale Semantic Correlation Mining for Visible-Infrared Person Re-Identification”被模式識别與人工智能領域國際頂級期刊《Pattern Recognition》接受,并在線發表。論文第一作者為2022級碩士研究生華雪成同學,BETVLCTOR伟德中文网站程科教授為通訊作者,BETVLCTOR伟德中文网站為第一完成單位,BETVLCTOR伟德中文网站塗娟娟副教授,江蘇大學陸虎副教授、河北工業大學王元全教授和江南大學王士同教授為論文共同作者。

(https://doi.org/10.1016/j.patcog.2024.111090)

行人重新識别(ReID) 是一種檢索攝像機拍攝的行人圖像中的人物的技術。随着公共安全的日益重視,全天候監控和檢索系統在計算機視覺領域引起了極大關注。現有的 ReID 方法主要用于檢索 RGB-RGB 圖像之間的行人信息。但是現實環境是複雜多變的,除了白天外,大多數在線監控場合都在夜間和低光照條件下。為了解決這個問題,許多全天候監控系統都采用了紅外 (IR) 攝像機來捕捉弱光環境下的場景。然而,紅外光的較長波長和散射增加會導緻可見圖像中通常存在的顔色、紋理和細節信息的丢失。因此,由于跨模态差異很大,需要針對RGB和IR圖像的不同特性設計一種用于可見光-紅外行人檢測的模型。

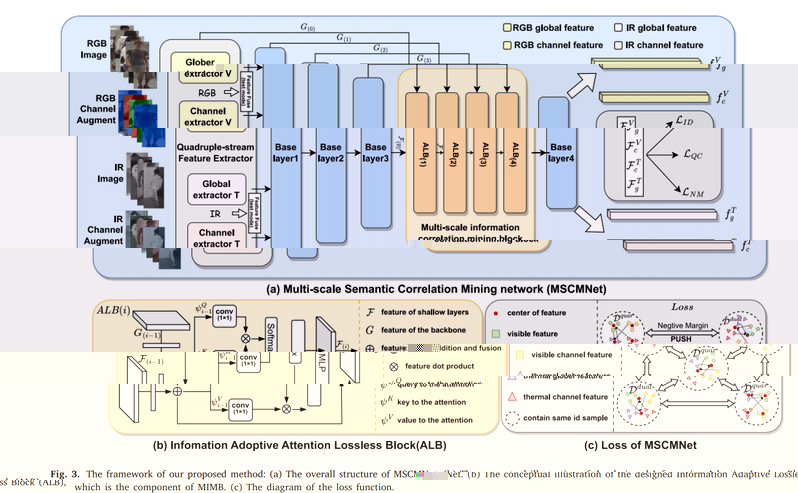

為了充分挖掘RGB-IR的模态信息,研究提出了基于深度學習的多尺度語義關聯挖掘網絡MSCMNet。通過設計多尺度信息關聯挖掘塊 (MIMB) 探索融合特征的隐含語義關聯,并設計四流特征提取器 (QFE) 盡可能保留原始數據的不同的語義信息。最後提出了一種新穎的四中心三元組損失 (QCT) 來處理跨模态特征中的語義信息差異。大量SYSU-MM01、RegDB 和 LLCM 數據集上的實驗表明我們提出的 MSCMNet 在 VI-RelD 任務中的表現優于目前其他最先進的方法。

《Pattern Recognition》被認為是模式識别與人工智能領域的頂級國際期刊之一,創刊于1968年。2023年該期刊的影響因子為8.0,屬于中科院計算機科學SCI一區TOP期刊。中國自動化學會(CAA)則将其列為A類推薦期刊,中國計算機學會(CCF)評價該期刊為“國際重要期刊,具有重要的國際學術影響力”。